Le consensus scientifique à l’épreuve des coûts économiques

Les modèles climatiques mondiaux (GCM) actuels, tels qu’ils sont présentés dans le sixième rapport d’évaluation (AR6) du GIEC publié en 2021, affichent une confiance élevée : la quasi-totalité du réchauffement de surface observé depuis la période préindustrielle (1850-1900), soit un peu plus de 1 °C, est attribuée à l’augmentation des gaz à effet de serre et à d’autres forçages anthropiques. Ces projections, élaborées selon différentes trajectoires socio-économiques (SSP), constituent aujourd’hui le socle des stratégies mondiales d’atténuation visant la neutralité carbone.

L’interprétation dominante dicte que seules des politiques climatiques de type « net-zero » permettront de contenir les dommages futurs dans des limites acceptables. Cependant, ces politiques engendrent des coûts économiques et sociétaux extrêmement élevés. Dès lors, une question cruciale se pose : l’état actuel de la science climatique justifie-t-il pleinement ces coûts immédiats et certains ?

Une étude intitulée « Detection, attribution, and modeling of climate change: Key open issues », publiée dans la revue Gondwana Research, invite à un examen plus minutieux. En analysant les ensembles de données d’observation, les preuves paléoclimatiques et la performance des modèles, ce travail révèle une image bien plus complexe que celle généralement admise. Ces questions non résolues sur l’interprétation des climats passés et la projection des climats futurs sont déterminantes, car elles influencent des décisions qui façonneront les économies pour les décennies à venir.

Le « battement de cœur » oublié de la variabilité naturelle

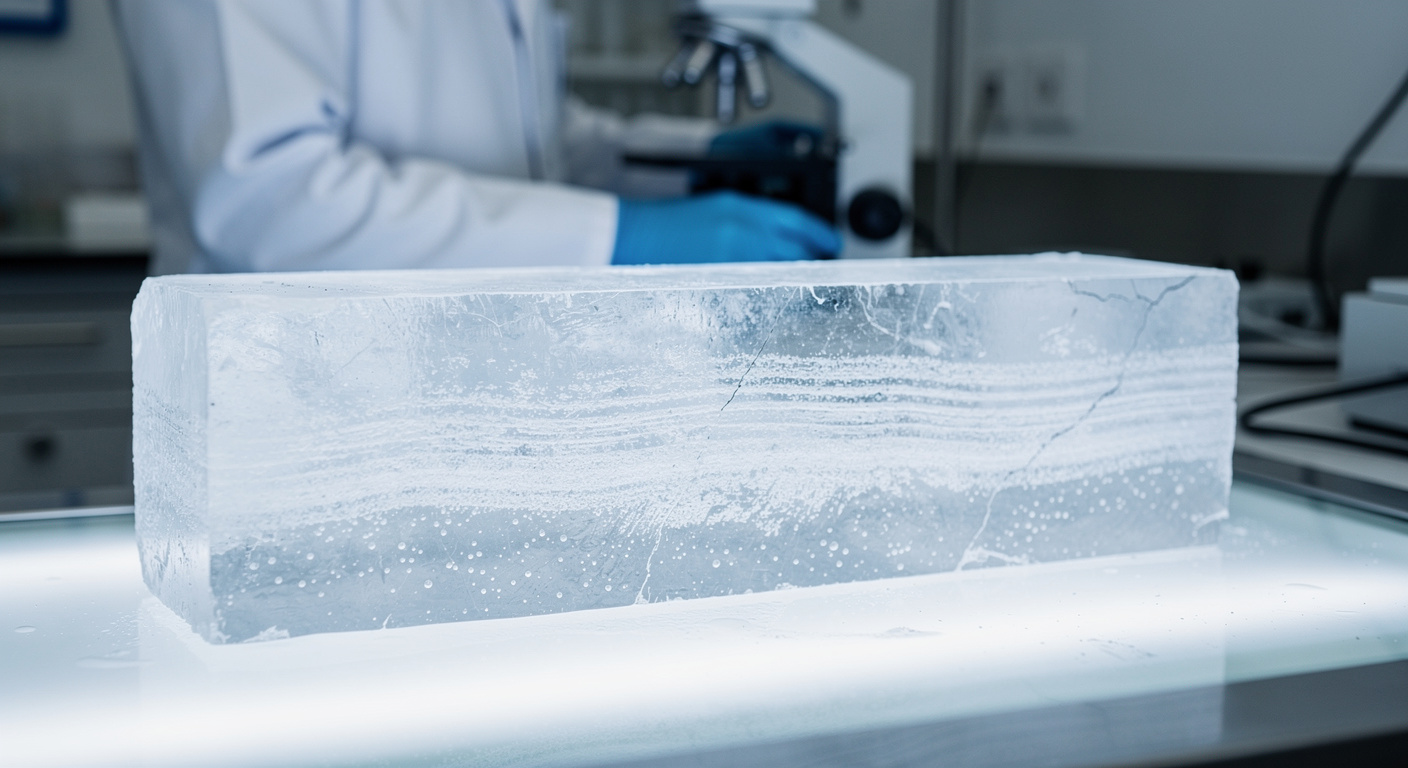

Un thème central de cette recherche est la variabilité naturelle du climat. Au cours de l’Holocène, soit les 11 700 dernières années, le système climatique a traversé un Optimum Climatique (il y a 6 000 à 8 000 ans) et a connu des oscillations répétées : cycles multi-décennaux, fluctuations centennales et réorganisations à l’échelle millénaire. Certains de ces cycles longs sont bien documentés, comme le cycle quasi-millénaire d’Eddy, associé aux périodes chaudes médiévale et romaine, ou le cycle de Hallstatt-Bray, d’une durée de 2 000 à 2 500 ans. Ces motifs sont inscrits dans les carottes de glace, les sédiments marins, les cernes des arbres, les documents historiques et les enregistrements indirects de l’activité solaire.

Le problème soulevé est que les modèles GCM actuels peinent à reproduire l’Optimum de l’Holocène ainsi que ces rythmes naturels. S’ils génèrent bien une variabilité interne, celle-ci ne correspond ni au timing, ni à l’amplitude, ni à la persistance observés dans la nature. Lorsqu’un modèle échoue à capturer ce « battement de cœur » naturel du système, il devient ardu de distinguer le réchauffement d’origine humaine du bruit de fond naturel.

Cette lacune est particulièrement pertinente pour l’analyse de la période post-1850. En effet, les cycles d’Eddy et de Hallstatt-Bray sont tous deux en phase ascendante depuis approximativement le XVIIe siècle. L’étude suggère ainsi qu’une partie du réchauffement observé depuis l’ère industrielle pourrait découler de ces longues oscillations naturelles, dont les pics sont attendus respectivement au XXIe siècle et dans la seconde moitié du troisième millénaire.

Les incertitudes des thermomètres : surface contre satellites

L’évaluation du réchauffement climatique repose sur des ensembles de données de température de surface mondiale qui, bien qu’essentiels, ne sont pas exempts de défauts. L’urbanisation, les changements d’affectation des sols, le déplacement des stations météorologiques et les modifications de l’instrumentation peuvent introduire des biais non climatiques. Bien que de nombreuses corrections existent, des incertitudes demeurent, et même de faibles biais non résolus peuvent influencer les tendances à long terme.

L’étude met en lumière des divergences connues et significatives. Depuis 1980, les estimations basées sur les satellites pour la basse troposphère indiquent un réchauffement inférieur d’environ 20 à 30 % à celui rapporté par les relevés de surface, une différence particulièrement marquée au-dessus des terres de l’hémisphère Nord. De plus, des reconstructions récentes s’appuyant uniquement sur des stations rurales confirmées montrent également un réchauffement séculaire nettement plus faible.

Ces écarts soulignent la nécessité d’une surveillance continue et rigoureuse des enregistrements d’observation, car ils remettent en question la précision absolue des jeux de données utilisés comme colonne vertébrale de l’évaluation climatique actuelle.

Soleil complexe et modèles « trop chauds »

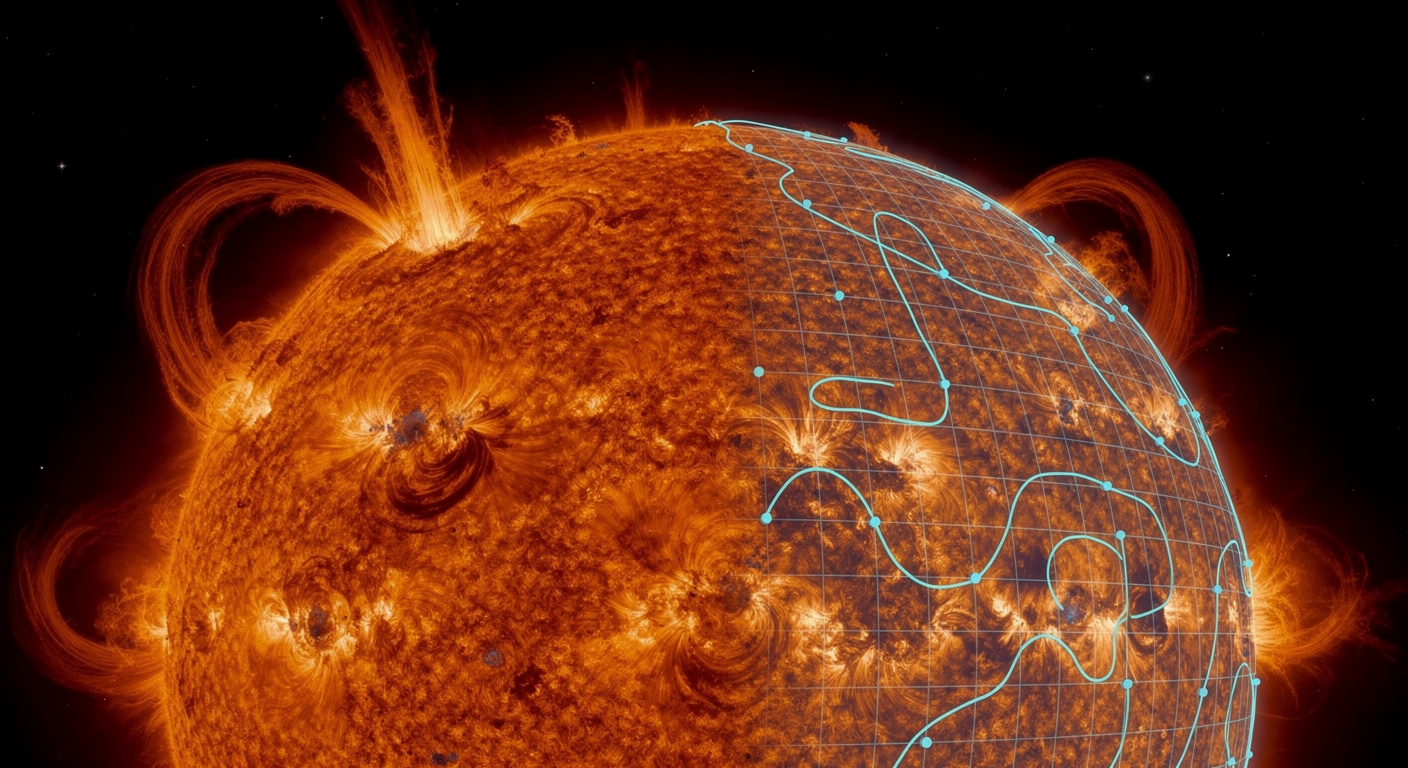

L’influence solaire et astronomique constitue un autre domaine où la science continue d’évoluer. Le soleil varie de manière plus complexe que ne le suggèrent les reconstructions simplifiées de l’irradiance utilisées dans de nombreux modèles. Plusieurs preuves indiquent que le climat réagit non seulement à l’irradiance solaire totale, mais aussi aux variations spectrales, à la modulation magnétique et aux effets indirects sur la circulation atmosphérique. Bien que des preuves empiriques suggèrent que ces mécanismes pourraient jouer un rôle dominant — potentiellement supérieur au simple forçage par l’irradiance totale — leur représentation dans les modèles reste incomplète.

Paradoxalement, malgré les controverses sur la variabilité solaire à long terme, les GCM actuels sont généralement forcés avec des reconstructions solaires présentant une variabilité séculaire extrêmement faible. Cela explique pourquoi ces modèles attribuent près de 0 °C du réchauffement post-1850 aux changements solaires et échouent simultanément à reproduire les oscillations millénaires visibles dans les archives paléoclimatiques. De plus, les comparaisons directes montrent que les modèles ne reproduisent pas l’oscillation climatique quasi-sexagénaire (60 ans) associée au réchauffement des années 1940 et tendent à surestimer le réchauffement observé depuis 1980. Ce problème de « modèle chaud » affecte une fraction substantielle des GCM actuels.

Tout cela renvoie à un paramètre clé : la sensibilité climatique à l’équilibre (ECS). L’estimation canonique du GIEC — environ 3 °C pour un doublement du CO₂, avec une fourchette probable de 2,5 à 4,0 °C — provient largement d’évaluations basées sur des modèles. Or, des études empiriques prenant mieux en compte la variabilité naturelle suggèrent souvent des valeurs plus basses, autour de 2,2 ± 0,5 °C, voire aussi basses que 1,1 ± 0,4 °C si la luminosité solaire à long terme varie significativement et si d’autres mécanismes solaires sont impliqués.

Vers une révision des stratégies : adaptation ou atténuation ?

Si la sensibilité climatique (ECS) est effectivement inférieure aux hypothèses courantes, le réchauffement projeté pour le XXIe siècle serait considérablement réduit, et ce, pour tous les scénarios socio-économiques (SSP). L’interaction entre facteurs naturels et anthropiques apparaît donc nettement plus nuancée qu’on ne le présente souvent. Lorsque des modèles empiriques incluant les oscillations naturelles sont utilisés pour projeter les températures futures, le résultat typique est un réchauffement modéré plutôt que des trajectoires extrêmes. Cela soulève des questions fondamentales sur la base scientifique justifiant les voies d’atténuation les plus agressives.

Une comparaison présentée dans l’étude met en perspective le réchauffement attendu par les GCM (évalués par le GIEC) avec les attentes dérivées de la modélisation empirique. Alors que les voies « net-zero » comme le scénario SSP1 sont considérées comme nécessaires pour respecter l’objectif de l’Accord de Paris (limiter le réchauffement sous les 2 °C d’ici 2100), les considérations empiriques suggèrent que ce même objectif pourrait être atteint sous le scénario SSP2, beaucoup plus modéré.

Cette distinction porte des implications économiques mondiales majeures. Le récit dominant de la crise climatique ne semblant pas être entièrement soutenu par l’ensemble des preuves, des stratégies d’adaptation, bien moins coûteuses, pourraient s’avérer plus appropriées que des politiques d’atténuation hautement agressives. L’étude insiste sur l’importance de traiter ces questions ouvertes : la politique climatique doit être éclairée par le spectre complet des preuves scientifiques, y compris les incertitudes et les interprétations alternatives.

Selon la source : phys.org

Créé par des humains, assisté par IA.

Climat : et si les modèles actuels sous-estimaient les facteurs naturels ?

Ce contenu a été créé avec l'aide de l'IA.